9 Tips Mengoptimalkan SEO dengan meningkatkan Jatah Perayapan Google – Ketika kita mendengar kata-kata “optimasi mesin pencari atau yang dalam bahasa inggris Search Enggine Optimation / SEO,” apa yang Anda pikirkan? Saya langsung berpikir tentang faktor peringkat SEO, seperti;

Memilih tag yang tepat,

Menggunakan kata kunci yang relevan,

Memiliki sitemap bersih,

Memiliki elemen desain baik,

Serta aliran konten berkualitas tinggi, atau dengan kata lain koten yang kamu publish setiap hari di blog harus konsisten berkualitas. Karena SEO kini sudh sangat berbeda dengan masa lalu, kamu bisa membaca artikel sebelumnya berjudul Fakta SEO terbaru.

Intinya adalah tentang Crawl Budget (Jatah Perayapan)

Lalu, Apa yang harus dilakukan untuk meningkatkan perayapan mesin pencari di blog kita ?

Apa itu istilah crawl budget mesin pencari (jatah perayapan mesin pencari)

Layanan web dan mesin pencari menggunakan web crawler bots, alias “laba-laba perayap/ spider,” untuk merayapi halaman-halaman web, mengumpulkan informasi tentang mereka, dan menambahkannya ke indeks pencarian. “Laba-laba” ini juga mendeteksi link pada halaman yang mereka kunjungi dan berusaha merayapi halaman-halaman baru.

Contoh bot yang akrab bagi kita salah satunya Googlebot, googlebot ini fungsinya menemukan halaman-halaman baru lalu menambahkan mereka ke Google Index, atau BingBot untuk layanan milik Microsoft.

Kebanyakan alat SEO dan layanan web lainnya juga mengandalkan laba-laba perayap untuk mengumpulkan informasi.

Seperti misalnya informasi tentang, indeks backlink, seperti perusahaan index backlink WebMeUp, yang dibangun menggunakan laba-laba yang disebut BLEXBot, yang merayapi hingga 15 miliar halaman data backlink setiap harinya.

Crawl Bugget Search Enggine (Jatah Perayapan Mesin Pencari)

Adalah Jumlah berapa kali dan sering laba-laba mesin pencari menjelajah website kamu dalam rentang waktu penjatahan oleh mesin pencari misalnya google, Itu yang saya sebut sebagai ” Jatah Perayapan Mesin Pencari / crawl bugget.”

Jadi ;

Jika Googlebot menjelajahi situs Anda 32 kali per hari, kita dapat mengatakan bahwa anggaran crawl Google adalah sekitar 960 per bulan.

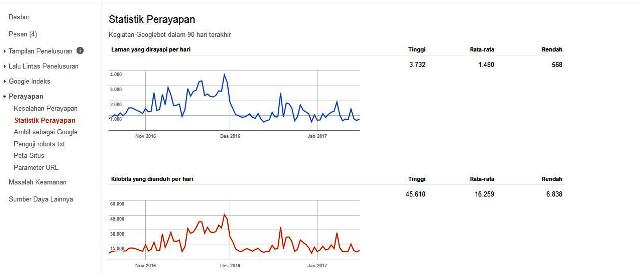

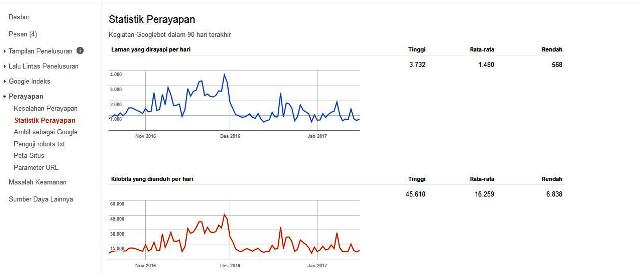

Anda dapat menggunakan alat seperti Google Search Console dan Bing Webmaster Tools untuk mencari “Crawl Bugget” perkiraan website Anda.

Caranya, login ke google webmaster/ google console -> Statistik Perayapan untuk melihat rata-rata jumlah halaman yang dirayapi laba-laba seperti googlebot per hari.

Apakah Mengoptimasi Crawl Bugget Sama dengan SEO (Search Enggine Optimation)?

Bisa Iya dan bisa tidak.

Kedua adalah jenis optimasi yang bertujuan untuk membuat halaman Anda lebih terlihat dan dapat mempengaruhi SERPs Anda di mesin pencari seperti google.

SEO lebih menekankan pada pengalaman pengguna, sementara optimasi ‘spider’/ laba-laba perayap sepenuhnya tentang bagaimana menarik dan mengatur bot perayap.

Neil Patel mengatakan pada KISSmetrics:

“Search engine optimization lebih terfokus pada proses mengoptimalkan permintaan pengguna. Sementara optimasi Googlebot difokuskan pada bagaimana crawler Google mengakses situs Anda. “

Jadi bagaimana cara mengoptimalkan Jatah Perayapan di blog kamu ?

Saya mengumpulkan sembilan tips untuk membantu Menjadikan website/ blog kamu sesering mungkin dirayapi ‘ spider’

#1. Pastikan halaman situs Anda apakah crawlable / bersahabat dengan mesin perayap

Halaman Anda mudah dirayapi adalah jika spider mesin pencari dapat menemukan dan mengikuti link-link dalam website Anda, Jadi kamu harus mengkonfigurasi .htaccess dan robots.txt dan pastikan keduanya tidak memblokir halaman penting pada situs Anda.

Dan kamu juga bisa mengecualikan halaman-halaman dalam situs kamu agar tidak di rayapi mesin pencari, namun perhatikan dengan seksama jika ini akan kamu lakukan, karena halaman tersebut tidak akan muncul di mesin pencari seperti google

Untuk mengecualikan perayapan mesin pencari tidak cukup hanya mengatur Robots.txt Anda dengan perintah ” Disallow,” . Menurut Google: “Robots.txt Disallow tidak menjamin bahwa halaman tidak akan muncul dalam hasil pencarian google.”

Jika informasi eksternal (misalnya link masuk) di arahkan menuju lalu lintas halaman yang telah Andadisallowed, Google masih menganggap halaman tersebut relevan. Dalam kasus ini, Anda harus secara manual memblokir halaman dari indeks dengan menggunakan robot noindex meta tag atau header HTTP X-Robots-Tag.

Jika menggunakan

(1) meta tag noindex: Tempatkan meta tag berikut di <head> pada halaman Anda untuk mencegah crawler mengindeks halaman Anda:

noindex” />

(2) X-Robots-Tag: Tempatkan berikut kode berikut di HTTP header Anda untuk memberitahu crawler tidak mengindeks halaman:

X-Robots-Tag: noindex

Catatan : Jika Anda menggunakan meta tag noindex atau X-Robots-Tag, kamu tidak usah lagi memblok/ Disallowed lagi pada robots.txt.

#2. Gunakan file multimedia dengan hati-hati

Ada suatu waktu ketika Googlebot tidak dapat merayapi konten seperti JavaScript, Flash, dan HTML. (meskipun Googlebot masih berjuang dengan Silverlight dan beberapa file lainnya).

Namun, sekalipun Google dapat membaca sebagian besar file multimedia Anda, belum tentu mesin pencari lainnya dapat merayapi, artinya bahwa kamu harus menggunakan file-file ini dengan bijaksana, dan lebih baik menghindari file-file tersebut sepenuhnya pada halaman yang memang ingin mendapatkan peringkat bagus di mesin pencari.

#3. Hindari Redirect Chains

Artinya adalah hindari pengalihan yang berturut-turut, misalnya url A ddi redirect ke url B dengan redirect 301 lalu di redirect ke url C menggunakan pengalihan 302 dan seterusnya.

Hindari hal tersebut !

Setiap URL kamu yang mengarahkan spam maka hanya sedikit jatah perayapan google untuk situs kamu.

Ketika website Anda redirect chains dalam waktu lama, misalnya dalam jumlah sejumlah besar pengalihan dalam 301 dan 302 secara berturut-turut, maka laba-laba seperti Googlebot mungkin berhenti merayapi sebelum mereka mencapai halaman tujuan Anda, Artinya halaman tidak akan diindeks.

Praktek terbaik tentang pengalihan adalah sebisa mungkin memiliki sedikit pengalihan di website Anda, dan tidak lebih dari dua kali pengalihan secara berurutan.

#4. Perbaiki Broken Links / Link Rusak

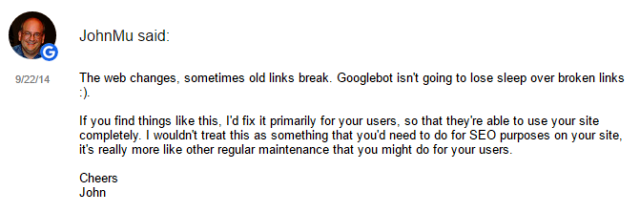

Ketika ditanya apakah link yang rusak mempengaruhi peringkat web, Google John Mueller pernah berkata:

Jhon Mueller mengatakan :

Jika Mueller mengatakan benar, ini adalah salah satu perbedaan mendasar antara SEO dan optimasi Googlebot, karena itu berarti bahwa link yang rusak tidak memainkan peran besar dalam peringkat, namun mereka sangat menghambat kemampuan Googlebot dalam mengindeks dan menempatkan peringkat website Anda.

Pengaruhnya mungkin kecil, namun algoritma Google selalu berkembang dan meningkat secara substansial selama bertahun-tahun, dan apa pun yang mempengaruhi pengalaman pengguna ini akan berdampak SERPs/ hasil pencarian google.

#5. Set Parameter pada URL Dinamis

Laba-laba meng treat URL dinamis yang mengarah ke halaman yang sama sebagai halaman yang terpisah, yang berarti Anda tidak perlu menghambur-hamburkan jatah anggaran perayapan Anda pada google console.

Anda dapat mengelola parameter URL Anda dengan cara buka Google Search Console dan klik Crawl-> Parameter Pencarian. Dari sini, Anda dapat membiarkan Googlebot tahu apakah CMS Anda menambahkan parameter ke URL yang tidak mengubah konten halaman ini.

Misalnya jika kamu pengguna CMS WordPress, di sana ada pilihan permalink, pilihlah dengan parameter dinamis URL.

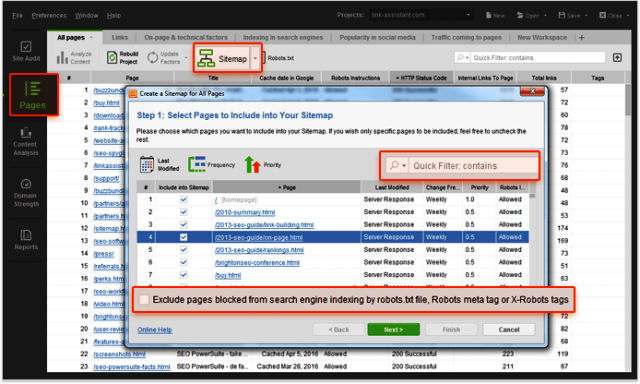

#6. Clean Up Peta Situs / Bersihkan sitemap Anda dari yang merusak

XML Sitemaps memiliki peran sama yaitu membantu pengguna dan bot spider, sitemap akan membuat konten Anda lebih terorganisir dan lebih mudah ditemukan.

Cobalah untuk menjaga sitemap Anda up-to-date dan membersihkannya dari setiap kekacauan yang dapat membahayakan kegunaan situs Anda. Misalnya seperti eror halaman 400, pengalihan yang tidak perlu, halaman non-kanonik, dan memblokir halaman.

Cara termudah untuk membersihkan sitemap adalah dengan menggunakan alat seperti website Auditor (disclaimer: alat saya). Anda dapat menggunakan generator XML sitemap website Auditor untuk membuat sitemap bersih yang mengecualikan semua halaman diblokir dari pengindekan.

Kamu juga bisa memenfaatkane Audit Situs, Anda dengan mudah menemukan dan memperbaiki semua 4xx halaman status, 301 dan 302 pengalihan, dan halaman non-kanonik.

#7. Gunakan Feed

Feed, seperti RSS, XML, dan Atom, memungkinkan situs web untuk menyampaikan konten ke pengguna bahkan ketika mereka tidak sedang berada di website Anda.

Hal ini memungkinkan pengguna untuk berlangganan ke situs favorit mereka dan menerima update rutin setiap kali konten baru diterbitkan.

RSS feed sudah lama menjadi cara baik untuk meningkatkan pembaca Anda dan keterlibatan, RSS feed juga salah satu situs paling sering dikunjungi oleh Googlebot. Ketika blog kamu menerima update (produk baru, posting blog, pembaruan website, dll) kemudian mengirimkannya ke feed Burner untuk mempercepat pengindeksan otomatis.

#8. Membangun Link Eksternal dengan baik

Link building masih menjadi topik panas para web developer, dan saya berkeyakinan topik ini akan berlangsung lama.

‘SEJ Anna Crowe ‘ dengan elegan menanggapi :

“Memperbanyak hubungan online, menemukan komunitas baru, membangun nilai brand – ini adalah bukti kecil kejayaan dari sebuah proses perencanaan link . Meskipun ada unsur yang berbeda dari membangun link yang sekarang dengan tahun 1990, namun intinya manusia akan tetap berhubungan dengan orang lain dan tidak akan pernah berubah. ”

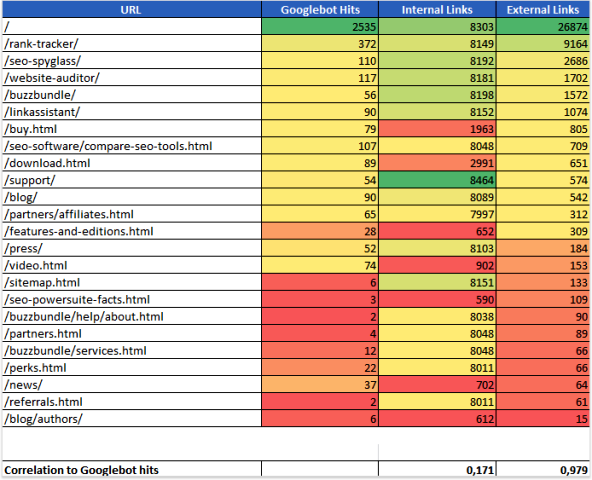

Dari pernyataan luar biasa di atas , ada bukti dari percobaan Yauhen Khutarniuk bahwa link eksternal erat berkorelasi dengan jumlah kunjungan spider website yang diterima.

Dalam eksperimennya, ia menggunakan alat untuk mengukur semua link internal dan eksternal yang menuju ke setiap halaman di 11 lokasi yang berbeda. Dia kemudian menganalisis statistik crawl pada setiap halaman dan membandingkan hasilnya. Ini adalah contoh dari apa yang ia temukan di salah satu situs yang dianalisis:

Data tersebut tidak bisa membuktikan adanya hubungan yang pasti antara link internal dan tingkat perayapan, Khutarniuk tidak menemukan keseluruhan “korelasi yang kuat (0,978) antara jumlah kunjungan spider dan jumlah link eksternal.”

#9. Menjaga link internal yang saling terintegrasi

Sementara percobaan Khutarniuk membuktikan bahwa membangun link internal tidak memainkan peran besar dalam tingkat perayapan, itu tidak berarti Anda mengabaikan membangun internal link.

Sebuah struktur situs yang dijaga dan terintegrasi dengan baik akan membuat konten Anda mudah ditemukan oleh bot pencarian.

Sebuah struktur link internal yang terorganisasi dengan baik, dapat meningkatkan pengalaman pengguna, pengguna dapat mencapai daerah manapun dari situs Anda.

Ini akan membuat semua lebih mudah diakses, berarti pengunjung akan berlama-lama di situs kamu, dan akhirnya dapat meningkatkan posisi SERPs Anda.

Jadi dapat di katakan ini adalah hubungan sebab akibat.

Kesimpulan:

Saran terbaik adalah meningkatkan crawlability dan cenderung akan meningkatkan searchability website juga.

Sederhananya,

Ketika kamu membuat lebih mudah bagi Google untuk menemukan dan mengindeks situs web Anda, kamu akan menikmati lebih banyak perayapan ke situs, yang berarti index akan lebih cepat ketika Anda mempublikasikan konten baru.

Kamu juga akan meningkatkan pengalaman pengguna secara keseluruhan, yang kemudian akan meningkatkan visibilitas, dan akhirnya menghasilkan peringkat SERPs lebih baik.

Demikian panduan 9 Tips Mengoptimalkan SEO Dengan Meningkatkan Perayapan Googlebot, semoga bermanfaat. Salam,

Semoga ka

Semoga setelah menjalankan tips ini blog kita bisa mudah diindeks google. Belakangan ini susah bener biar terindeks.

Sama-sama,,semoga artikel ini membantu Anda dalam meningkatkan rangking website..

Artikel yang sangat bermanfaat, saya jadi dapat pencerahan nih untuk meningkatkan ranking web saya, thanks gan atas ilmunya